Индексация веб‑сайта делает ваш ресурс видимым в поиске: это занесение данных о страницах в базы поисковых систем, например Google. Пока страница не внесена в индекс, её нельзя найти по запросу — как книга без каталожной карточки в большой библиотеке. Даже отличное содержание и аккуратный дизайн не помогут, если сайт остаётся невидимым для поисковых роботов.

Поисковые роботы, или краулеры, — это программы, которые обходят страницы, считывают их содержимое и отправляют данные в индекс. Они учитывают текст, изображения, видео, ссылки и другие элементы страницы. Если контент отвечает требованиям качества и релевантности, страница попадает в индекс и может показываться в результатах поиска.

При обнаружении проблем — дублированного текста, вредоносного кода или явных нарушений — к сайту могут применить санкции. В результате страница либо исключается из выдачи, либо остаётся в индексе, но не получает органического трафика. Индексация напрямую влияет на видимость и приток посетителей: без неё сайт остаётся незаметным для целевой аудитории.

Как работают поисковые роботы

Процесс обхода и обработки страниц включает несколько ключевых этапов:

- обход — последовательное посещение страниц по ссылкам;

- анализ — извлечение текста, метаданных и структуры страницы;

- индексирование — занесение полученных данных в поисковый индекс;

- ранжирование — сортировка результатов по релевантности и авторитетности.

Алгоритмы поисковых систем постоянно обновляются. Google, например, внедряет механизмы вроде RankBrain и BERT, чтобы лучше понимать контекст запросов и естественный язык, что усложняет и одновременно делает точнее процесс индексации и ранжирования.

Как проверить индексацию сайта

Регулярная проверка индексации помогает убедиться, что важные страницы доступны для поисковых систем и нет технических препятствий.

Самый простой способ

Для быстрой проверки используйте эти запросы в поисковой строке:

- site:вашсайт.com — показывает все проиндексированные страницы домена;

- cache:адрес_нужной_страницы.com — показывает кэшированную версию и дату последнего сканирования;

- site:адрес_нужной_страницы.com — проверяет наличие конкретной страницы в индексе.

Использование специализированных инструментов

Для глубокого анализа применяйте официальные сервисы поисковых систем.

Индексация сайта в Google

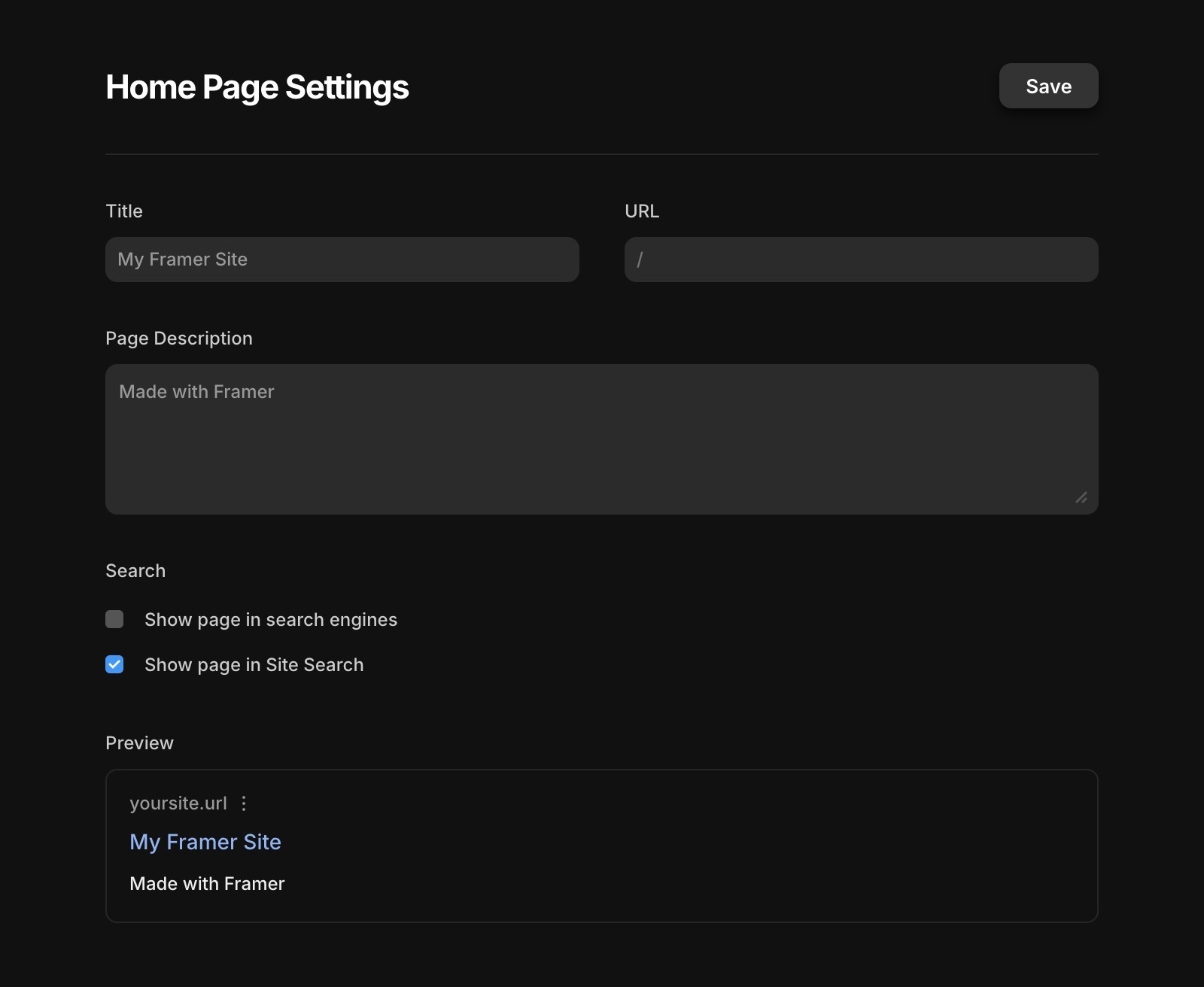

Google Search Console даёт детальную картину статуса сайта: какие страницы проиндексированы, какие исключены и почему. Через консоль можно запросить повторную индексацию отдельных URL после обновления контента.

Важно понимать: поисковый робот может сканировать страницу, но не показывать её в выдаче, если она не отвечает требованиям качества или содержит ошибки.

Что сканируют поисковики и сколько времени уходит на индексацию

Роботы оценивают множество факторов, чтобы понять, насколько страница полезна и релевантна. Среди главных критериев выделяют:

- качество и уникальность контента;

- техническое состояние сайта;

- структура сайта и внутренняя перелинковка;

- внешние ссылки с авторитетных ресурсов;

- поведенческие факторы пользователей.

Если серьёзных ошибок нет, индексация может занять от суток до нескольких дней. Для новых сайтов или крупных ресурсов с большим объёмом контента этот срок может увеличиваться. Частота обхода зависит от авторитетности сайта и частоты обновлений.

Как закрыть сайт от индексации

Иногда нужно временно или выборочно скрыть страницы от поисковых роботов. Чаще всего это нужно в таких случаях:

- разработка или реконструкция сайта;

- технические или служебные страницы;

- низкокачественный или устаревший контент.

Запретить сканирование можно двумя основными способами:

- Через файл robots.txt.

- Через метатег robots на странице.

1. Через файл robots.txt:

Файл robots.txt размещается в корне сайта и указывает роботам, какие разделы не следует сканировать. Пример запрета для всех роботов:

User-agent: * Disallow: /

Директива User-agent: * охватывает всех роботов, а Disallow: / блокирует доступ ко всему сайту.

2. Через метатег robots:

Для скрытия отдельных страниц в секцию <head> добавляют метатег:

<meta name="robots" content="noindex, nofollow">

Атрибут noindex инструктирует робота не включать страницу в индекс, а nofollow запрещает переходить по ссылкам с этой страницы.

Как ускорить индексацию сайта

Чтобы поисковые роботы быстрее находили новые или обновлённые страницы, используйте проверенные приёмы:

- выбор надёжного хостинга;

- ручная отправка URL на индексацию через инструменты поисковой системы;

- корректная настройка файла robots.txt;

- создание и актуализация sitemap.xml;

- устранение дубликатов страниц;

- оптимизация контента по объёму и релевантности;

- регулярное обновление материалов;

- настройка логичной внутренней перелинковки;

- оптимизация изображений и видео;

- улучшение юзабилити и поведенческих факторов.

Почему индексация страниц сайта важна

Попав в индекс, сайт становится доступным для людей, которые ищут ваши товары или услуги. Без индексации потенциальные клиенты просто не найдут ресурс, независимо от того, насколько он хорош.

Представьте магазин без вывески и отметки на карте: он может стоять на лучшем месте, но никто туда не придёт. То же и с сайтом — индексация делает его заметным и приносит органический трафик, который часто ценнее платного.

Индексация — первый шаг к видимости, росту посещаемости и увеличению продаж. Игнорировать этот этап значит упускать реальную возможность развития онлайн‑проекта.